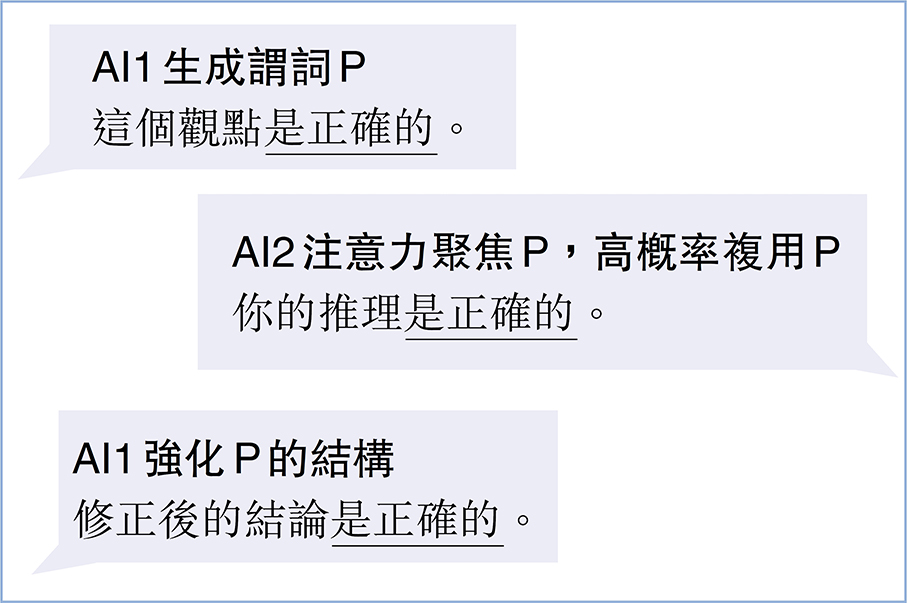

如果你嘗試讓兩個AI對話,可能就會發現它們總在複讀同一個詞語(見圖)。

顯而易見,兩個AI不停地重複使用謂詞「是正確的」。重複在人類對話中較少見,因為人類會主動避免重複用詞,那為什麼AI與AI對話會出現這種情況,難道AI都是「複讀機」嗎?

實際上,此現象是模型數學機制與對話場景特性共同導致的必然結果。這種現象的根源在於Transformer架構的數學特性,並非設計缺陷,而是數學必然,是參數化輸出的自然體現。若能理解這點,就能區分「AI在模仿思維」和「數學概率顯現」的本質差異。

要解釋這一點,首先引入一階謂詞的概念。一階謂詞是邏輯學中描述對象屬性或對象間關係的運算式,其核心特徵是僅作用於單個對象(而非邏輯本身或更高階概念),不嵌套其他謂詞。語言學中也將其表述為「主系表結構」。

如:小明是學生(判斷個體屬性),其中「是學生」就是一階謂詞。又如:該結論需要驗證(聲明對象狀態),其中「需要驗證」是一階謂詞。

第一個原因是高頻短語權重固化,當對話中反覆出現相同語義(如「正確」)時,自注意力機制會持續為其分配高權重,導致後續生成時相同謂詞的概率被顯著放大。

「是X」這類簡單謂詞在訓練數據中本就常見,更關鍵的是在AI-AI對話場景中缺乏人類對話的隨機擾動,形成封閉的概率強化循環:第一個AI用「是必要的」收尾,第二個AI的注意力機制會優先捕獲這個謂詞,進而生成類似結構,如此循環。

同時,開發者通常設置低溫(temperature≈0)以保證AI回覆穩定性,這使模型更傾向選擇歷史對話中的最高概率組合(如「是XX」結構)。

AI沒有「厭倦」機制,其temperature參數若設置較低,就會持續選擇最高概率的謂詞組合。

第二個原因是缺乏外部輸入干擾。人類對話會引入新資訊打破循環,但AI-AI對話僅在兩者參數框架內交換文本,形成封閉系統。當一方使用謂詞P,另一方會將其視為強上下文信號,直接複用P成為概率最優解。若初始回覆含謂詞P,後續對話會圍繞P展開。模型因無法自主跳出該語義域,導致P反覆出現。

第三個原因是結構簡單性優先。一階謂詞(主系表結構)在訓練數據中佔比極高,其數學表示的生成路徑最短,計算成本最低。

此外,有的開發者會通過系統提示詞要求AI「保持明確斷言」,而一階謂詞能直接傳遞確定性,符合安全合規要求。

總結而言,AI複讀的現象是基於概率的文本生成機制在封閉對話環境中的自然體現,開發者雖然可以通過提升temperature參數或注入隨機擾動緩解,但無法徹底消除。

●文鯉

評論